前回は「ディレクトリ型検索エンジン」について解説しました。今回はもう1つの検索エンジンである「ロボット型検索エンジン」について解説します。

ロボット型検索エンジンの意味

まずはロボット型検索エンジンとは一体何かですが、インターネット上の情報を自動で収集し、データベースに登録して、順位を付けるシステムのことを言います。これにより、ユーザーはキーワードを入力するだけで、関連するウェブページや情報を瞬時に検索することができるというものです。

ロボット型検索エンジンの歴史は意外と古く、Googleの登場よりも前にさまざまなブランドが存在していました。たとえば、アルタビスタやエキサイト、Infoseek、goo、そしてインクトゥミといった名前が挙げられます。特にインクトゥミは、MSNやYahoo!JAPANが一時期使用していた専門の検索エンジンサービス提供会社で、独自のブランドを持っていました。

Googleが登場する前にいくつもの有名なロボット型検索エンジンが使われていた

ロボット型検索エンジンの世界においては、Googleがその後大きな影響力を持つようになりましたが、それ以前には様々なブランドが存在しておりユーザーに使われていました。また、それらロボット型検索エンジンに先駆けて人気を博していたのが、前回の記事で解説したディレクトリ型検索エンジンです。Yahoo!JAPANのYahoo!カテゴリがディレクトリ型検索エンジンの代表的な例で、こちらはウェブページをカテゴリ別に人間が手動で分類する方式を採用していました。

こうした検索エンジンの変遷を見ると、インターネットの進化と共に検索技術も大きく変化してきたことがわかります。今日では、私たちはより高速で精度の高い検索結果を当たり前のように享受していますが、それが可能になったのは、こうした歴史的な発展の結果なのです。

ディレクトリ型とロボット型検索エンジンの根本的な違い

ディレクトリ型検索エンジンとロボット型検索エンジンには、根本的な違いがあります。この違いを理解することで、なぜ現代の検索エンジンがロボット型を主流にしているのかが明らかになります。

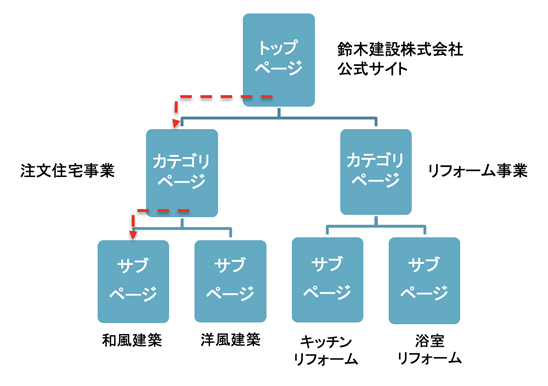

まず、ディレクトリ型検索エンジンであるYahoo!カテゴリは、このタイプの代表例です。ディレクトリ型検索エンジンでは、人が直接ウェブサイトを管理し、分類します。このアプローチには大きな限界がありました。なぜなら、ウェブサイトはトップページのみが登録され、その他のページは無視されがちだったからです。つまり、ユーザーはトップページから始めて、必要な情報を探し出さなければならないという手間が生じたのです。

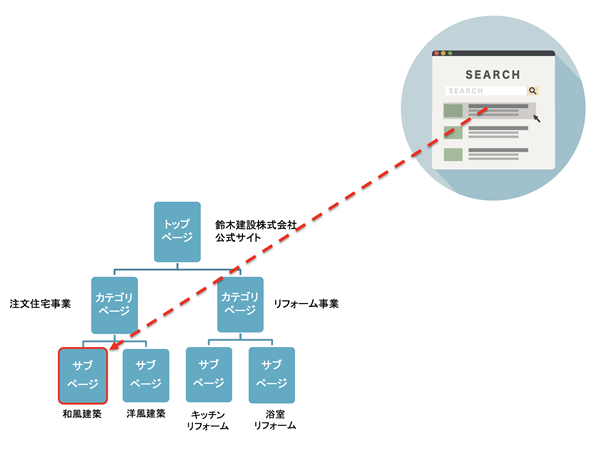

一方、ロボット型検索エンジンでは、この問題が解決されます。ロボット型では、ウェブサイトの全ページが登録されるため、例えば20ページあるウェブサイトであれば、その全てのページが検索結果に表示されやすくなります。これにより、ユーザーは検索結果ページから、サイト内にある自分が探しているページにすぐに到達することが可能になりました。

ディレクトリ型検索エンジンのもう一つの大きな問題は、人間による手作業での登録の限界です。人間が編集し、登録するため、ウェブサイトの数が膨大になると、全てを適切に扱うことが難しくなります。これにより、興味深いウェブサイトが登録されない、という問題が生じました。

さらに、ディレクトリ型検索エンジンでは、編集者の主観や運営会社の方針が、どのウェブサイトを登録するか、しないかの基準に大きく影響します。その結果、全てのウェブサイトが平等に扱われないという問題がありました。これは、質の高いサイトであっても、登録されない可能性があることを意味します。

このような背景から、ロボット型検索エンジンが現代のインターネットにおいて優位に立つようになったのです。これらの検索エンジンは、情報をより効率的に、そして公平に索引付けすることが可能になり、結果としてユーザー体験が大幅に向上したのです。

ロボット型検索エンジンの基本的な仕組み

ロボット型検索エンジンの登場と普及は、インターネットの検索技術において一大革命と言えるでしょう。この進歩は、従来の手作業によるディレクトリ型検索エンジンの限界を大きく超えたものでした。では、このロボット型検索エンジンの仕組みについて掘り下げてみましょう。

ロボット型検索エンジンの核心は「クローラー」と呼ばれるロボットプログラムにあります。このクローラーは、ウェブ上のリンクを自動的にたどりながら情報を収集し、それをデータベースに登録します。このプロセスにより、リンクされているウェブページはもちろん、サイト内のナビゲーションメニューやフッターリンクを通じて接続されているページも個別に登録されます。

ロボット型検索エンジンのメリット

そのメリットは明白です。ロボット型検索エンジンでは、ウェブページ単位で情報が登録されるため、ユーザーが探している具体的な情報を含むページが直接検索結果に表示されます。これにより、ユーザーはより迅速かつ正確に必要な情報にアクセスできるようになったのです。

さらに、ロボット型検索エンジンのもう一つの大きなメリットは、最新情報の迅速な更新です。クローラーは定期的に新しい情報を収集し、データベースを更新するため、常に最新のウェブページが検索結果に反映されるようになります。これは、人手によるチェックが必要なディレクトリ型検索エンジンのYahoo!カテゴリとは大きく異なり、新鮮な情報が得られる点で非常に魅力的です。

ディレクトリ型検索エンジンでは、新しい情報の登録が遅れるため、古いサイトが長期間ディレクトリに残るという問題がありました。しかし、ロボット型検索エンジンでは、大量の情報がデータベースに登録されることで、この問題を解消しました。結果として、ロボット型検索エンジンは情報量においてディレクトリ型を圧倒し、面白くて役立つ情報を幅広く提供することが可能になったのです。このように、ロボット型検索エンジンの登場は、インターネット上の情報探索において、革新的な進歩をもたらしたのです。

ロボット型検索エンジンのデメリット

このように便利なロボット型検索エンジンが当然デメリットが無いわけではありません。確かに、ロボット型検索エンジンは情報の量という点では優れていますが、その豊富さが逆に問題を引き起こすこともありました。

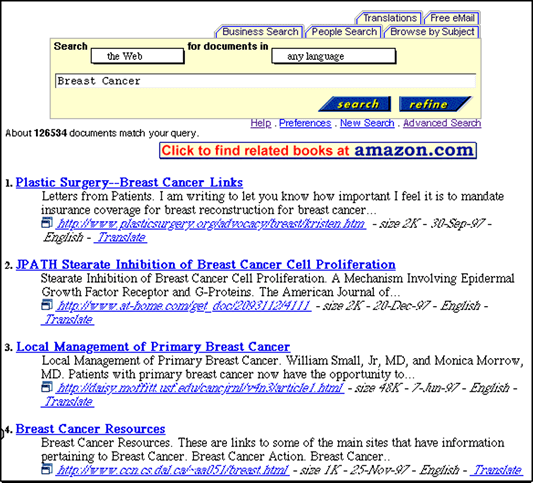

この問題の核心は、「情報過多」です。ロボット型検索エンジンがウェブページを大量に索引付けすることにより、ユーザーは膨大な情報の海にさらされるようになりました。その結果、どの情報が本当に必要で、どれが不要なのかを見極めるのが難しくなったのです。ユーザーにとって無関係、あるいは意味のないページが検索結果の上位に表示されることも珍しくなく、これが検索体験を損なう要因となりました。

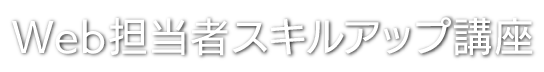

アルタビスタという検索エンジンを例にとると、その問題は顕著に見て取れます。この検索エンジンは、検索結果がごちゃごちゃしていて、わけのわからない言葉が含まれていることが多かったのです。文字や情報が混在しており、ユーザーが自分に関係のあるページを見つけるのが困難でした。

《アルタビスタの検索結果》

情報量が豊富であることは、一見するとメリットのように思えますが、この豊富さが逆に情報をごちゃごちゃにしてしまうというジレンマがあるのです。検索エンジンの開発者たちは、この問題にどのように対処するかという課題に直面しました。ユーザーにとって関連性の高い、価値のある情報を効率的に提供するためには、単に情報量を増やすだけでは不十分であり、情報の質と整理の仕方が重要になるのです。このようなデメリットの存在は、ロボット型検索エンジンの技術的な進化と洗練に大きな影響を与えてきました。

スパムという問題

ディレクトリ型検索エンジンとロボット型検索エンジンを比較すると、それぞれの利点と欠点が鮮明になります。例えば、Yahoo!カテゴリのようなディレクトリ型検索エンジンは、その使いやすさと整理された情報提供で知られていました。人間が直接ウェブサイトを審査し、精選したものだけを掲載していたため、不要な情報が排除され、検索結果は非常にスッキリとしていました。

しかし、この時代にはロボット型検索エンジンにも大きな問題がありました。それは、スパム行為による検索結果の乱れです。例えば、あるウェブページが「トヨタ」という言葉を用いることで、トヨタに関連する検索で上位に表示されるように操作していたのです。この問題は、特にアダルトサイトなどが悪用することが多く、関連性のないキーワードをページに埋め込むことで、不適切なコンテンツが一般の検索結果に混入してしまうケースが頻発しました。

この時代、Googleはまだ普及しておらず、アルタビスタやインクトゥミといった検索エンジンがこの種のスパム行為に悩まされていました。結果として、これらのロボット型検索エンジンは検索結果の混乱により、損害を受け、多くが市場から姿を消してしまいました。これらのエンジンは、ウェブページの内容の質や関連性を適切に評価するメカニズムが不足していたため、スパムによる悪影響を受けやすかったのです。

このように、検索エンジンの歴史は、情報の整理と提供の仕方をいかにうまく行かせるかという悩みとの戦いだと言って良いものでした。ディレクトリ型の精確さとロボット型の包括性が融合し、より高度な検索技術が求められるようになったのは、これらの経験があったからこそです。この時代の検索エンジンの苦悩は、現代の検索技術が直面する課題を理解する上で重要な教訓を提供しています。

何故Googleだけが勝ち残ったのか?

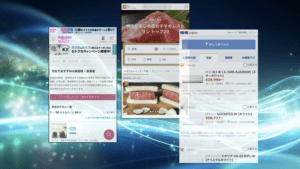

Googleが人気の検索エンジンになった理由は、多くの面で革新的だったことにあります。1997年に登場したGoogleは、短期間で大きな注目を集めるようになりました。その成功の鍵は、ユーザーの検索クエリに対して非常に関連性の高い結果を提供する能力にありました。ユーザーが入力したキーワードに対して、最も適切な情報が上位に表示されることが多く、これにより検索の効率が大幅に向上しました。

過去には、探しているウェブページを見つけるのに数十分から数時間かかることも珍しくありませんでした。しかし、Googleを使えば、数回のクリックだけで必要なコンテンツがすぐに見つかるという体験をユーザーは得ることができました。この速度と効率の高さは、当時としては驚異的なものでした。

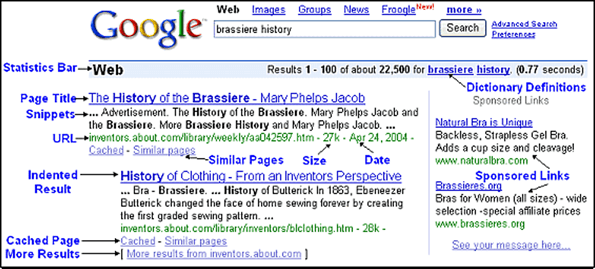

《2000年当時のGoogle英語版の検索結果画面》

《出典》 Google Guide

さらに、Googleの検索結果の表示速度も他の検索エンジンとは一線を画していました。キーワードを入力し検索ボタンを押すと、ほとんどの場合1秒以内に結果が表示されました。これに比べ、インクトゥミやアルタビスタなど他の検索エンジンでは、検索結果の表示に時間がかかることが多かったのです。

Googleの優れた表示スピードと関連性の高い検索結果は、検索エンジンに求められる要素をほぼ完璧に備えていました。このため、Googleはロボット型検索エンジン市場の覇者となり、日本では80%から90%近くのシェアを握るまでに成長しました。このように、Googleの成功は、ユーザーにとって価値のある情報を迅速かつ正確に提供する能力によって決定的なものとなったのです。

Yahoo!JAPANが独自検索エンジンを捨てるまでの経緯

Yahoo!JAPANが検索エンジンの歴史においてどのような役割を果たしたかを知ることは、検索技術の進化を理解する上で興味深いことです。2010年、Yahoo!JAPANは自社の検索エンジンをGoogleに変更しました。この変更の背景には、さまざまな試行錯誤と戦略的な判断がありました。

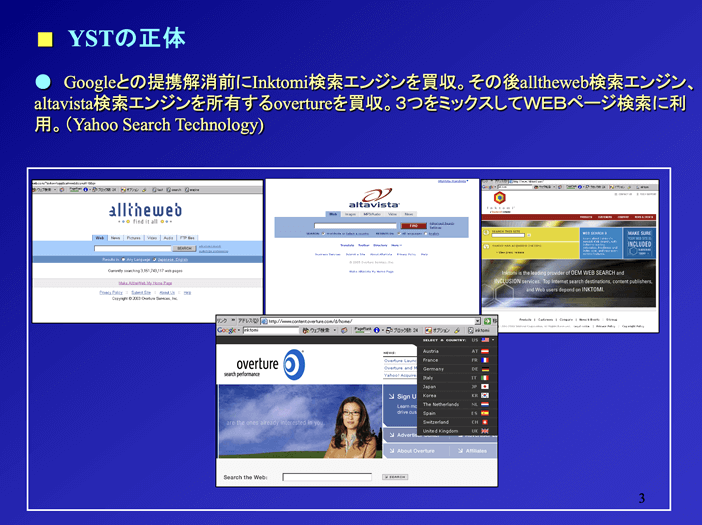

実は、Yahoo!JAPANは以前にも一時的にGoogleの検索エンジンを利用していた時期がありました。しかし、その後、米国のYahoo!という企業は自社の検索エンジンであるYST(Yahoo Search Technology)の開発に着手しました。これは、検索エンジンの会社であるインクトミと、もう一つのロボット型検索エンジンであるAllTheWebの買収を経て行われたものです。これらの検索エンジンは、Googleに比べると性能は劣っていましたが、それでも高い精度を持つ検索エンジンとして知られていました。

《YSTで上位表示をするための方法を解説するセミナー資料の一コマ》

しかし、このYahoo!独自のロボット型検索エンジンは、大量の情報が表示されることやスパム行為に弱いという問題に直面しました。SEO(検索エンジン最適化)を行う人たちによって容易に操作されてしまい、ユーザーが本当に見たい情報が上位に表示されなくなるという問題が発生したのです。結果として、スパム行為が巧みなサイトが上位に表示されるような状況に陥り、検索結果が混乱しました。

このような経緯を経て、Yahoo!JAPANは再びGoogleの検索エンジンを採用する決定を下したのです。この変更により、日本の検索市場の約90%がGoogleの手に渡ることになりました。

これはGoogleという企業の検索エンジンの品質向上に対する絶え間ない努力の賜物です。Googleはアルゴリズムを定期的にアップデートし、パンダアップデート、ペンギンアップデート、コアアップデート、ページエクスペリエンスアップデートなど、多くの改良を実施してきました。これにより、ユーザーが求める検索結果が得られるようになり、品質は格段に向上しました。

Googleの成功は、ディレクトリ型検索エンジンの利点を取り入れ、ロボット型検索エンジンの欠点を解決した結果です。技術力の面で圧倒的な勝利を収めたのがGoogleであり、その結果、私たちは日常的に、何度もGoogleを使用するようになりました。

まとめると、検索エンジンの進化はディレクトリ型から始まり、最終的にはロボット型が市場を制覇しました。そして、この戦いに勝利を収めたのはGoogleです。Googleの勝利は単なる偶然ではなく、努力と技術革新の産物です。この進化の歴史を通じて、私たちは検索エンジンの種類や特徴、そして成功の要因について深く理解することができます。

検索市場に生まれた新たなる戦い – 生成AI

Googleが開発中の生成型AI「Bard」と、Microsoftが出資しているOpenAIの「ChatGPT」の間の競争は、注目すべき技術的な戦いです。ChatGPTは、質問に対してほぼ瞬時に素晴らしい答えを返す能力を持っています。一方で、Googleも「Bard」という名前で類似のチャット型生成型AIを開発して公開しました。

現時点では、ChatGPTが有利な立場にあると言われていますが、Googleの「Bard」を侮ることはできません。Googleの強みは、必ずしも最初に発明することではなく、既存の技術を改良し、それを超える製品を開発する能力にあります。例えば、検索エンジンの分野では、Googleはアルタビスタやインクトゥミといった会社が普及させた技術を基に、ロボット型検索エンジンのデメリットを克服し、ディレクトリ型検索エンジンのメリットを取り込むことで、最高のプロダクトを開発しました。

企業としてのGoogleの凄さ

Googleのサービス展開戦略を見ると、彼らがどのようにして市場の覇者になったかが明らかになります。例えば、Gmailのケースを見てみましょう。Gmailが登場する前、電子メールの分野では、MicrosoftのHotmailが無料メールサービスの先駆けとして、そして後にYahoo Mailが人気を集めていました。しかし、GoogleはGmailを通じて、後から市場に参入し、結果的にメール市場のシェアを大きく獲得しました。

Googleの成功の鍵は、後発であるにも関わらず、徹底的な研究と改善を重ねることで、最高のプロダクトを開発することにあります。Gmailの例では、Googleは既存のメールサービスよりも優れた機能や使い勝手を提供し、メール市場の覇者となりました。

同様に、地図の分野でもGoogleの優位性は顕著です。多くの企業が地図サービスを提供している中で、Google Mapsは最も優れたサービスとして広く認識されています。実際、iPhoneユーザーの多くは、Appleが提供する独自のマップアプリよりもGoogle Mapsを好んで使用しています。これは、少しの使い勝手の違いが大きな影響を及ぼすことを示しています。

このようにGoogleは、既存のサービスを研究し、それを超える製品を開発することで、メールや地図など様々な分野で市場を制覇してきました。これらの事例は、Googleがいかにして市場のリーダーになったかを理解する上で非常に重要です。

Googleという企業の真の強みは、市場に後から参入するものの、先行者の弱点を徹底的に分析し、それらを克服した製品を開発することにあります。これは、検索エンジン市場における彼らの成功からも明らかです。そして、この戦略は、Googleが新たに注力している生成AIの分野にも適用される可能性が高いです。

現在、マイクロソフトとOpenAIが共同開発したChatGPTが大きな注目を集めていますが、Googleはこの新しい領域でも驚くべき製品、あるいは使い勝手の点でわずかな差が大きな違いを生むようなサービスを開発することができるでしょう。Googleのこれまでの歩みを見ると、彼らが単なる検索エンジン会社に留まらず、Web上で人気のあるサービスを改善し、市場を獲得することが得意であることがわかります。

Googleのこのようなアプローチは、彼らの企業としての本質的な強さを表しています。そのため、Googleの動向は今後も注目に値します。検索エンジンに限らず、生成AIやその他の新しい技術領域においても、Googleの影響力を過小評価してはなりません。

検索エンジンに関する解説を終えた今、次回はもう一つの重要なテーマである「ポータルサイト」についての解説に移ります。ポータルサイトの意味とその仕組を理解することは、ウェブを活用した集客を深く理解する上で不可欠です。それではまた。